Article Directory

AI普及带来的机遇与挑战:隐私、虚假信息与AI幻觉

国产大模型的崛起与AI的普及

近两个月来,国产大模型在性能和算法上不断创新,人工智能(AI)技术正以前所未有的速度渗透到人们的日常生活中,各种AI应用层出不穷,极大地提高了生产效率和生活便利性。从智能助手到自动驾驶,AI的影响力日益显著,预示着一个智能化时代的到来。

AI普及的潜在风险:隐私侵犯与虚假信息

然而,AI的迅猛发展也带来了一系列不容忽视的挑战。其中,最令人担忧的是AI技术对个人隐私的潜在威胁,以及虚假信息泛滥的风险。AI换脸、AI合成声音等技术,如果被滥用,可能导致名誉侵权、身份盗用等问题。此外,AI生成的内容真假难辨,使得虚假信息更容易传播,对社会秩序和公众信任造成冲击。

两会代表的呼吁:加强AI治理,规范技术应用

雷军:规范AI换脸拟声技术,明确应用边界

在今年的两会上,多位代表委员呼吁加强对AI乱象的治理,规范AI技术的应用。小米创始人雷军作为备受关注的企业家,特别强调了AI换脸和拟声技术带来的潜在风险。他建议加快相关立法进程,明确技术应用的边界,防止被不法分子利用。雷军坦言自己就是AI换脸拟声技术的受害者,网络上充斥着大量由AI配音的恶搞视频,给他的个人形象和声誉造成了不良影响。

靳东:警惕AI换脸诈骗,呼吁建立行业规范

著名演员靳东也表达了对AI换脸问题的担忧。他指出,一些不法分子利用AI换脸技术冒充他进行诈骗活动,导致许多喜爱他的观众上当受骗。靳东呼吁建立更完善的行业规范,加强对AI技术的监管,保护公众的合法权益,维护良好的社会秩序。

AI幻觉:从名人到普通人的困扰

AI幻觉的影响:真假难辨的信息

如果说AI换脸主要针对的是名人,那么AI幻觉则已经开始影响普通人的生活。在今年的两会期间,“AI幻觉”成为了代表们热议的高频词汇。AI幻觉指的是人工智能在生成内容时,出现与事实不符、逻辑混乱甚至完全虚构的情况。这种现象使得AI生成的信息真假难辨,给人们的生活带来了诸多困扰。

刘庆峰:警惕AI幻觉带来的数据污染与恶性循环

科大讯飞董事长刘庆峰指出,生成式人工智能存在幻觉,特别是深度推理模型的逻辑自洽性提升,反而使得AI生成的内容更加难以辨别真伪。更令人担忧的是,带有算法偏差的虚假信息会被新一代AI系统循环学习,形成“数据污染-算法吸收-再污染”的恶性循环。他呼吁整个行业高度关注AI幻觉信息充斥互联网可能造成的危害。

周鸿祎:AI幻觉在专业领域的潜在风险

360集团创始人周鸿祎也对AI幻觉问题表达了担忧。他认为,虽然AI幻觉在文学创作方面可能有所帮助,但在AI安全方面,幻觉可能会带来非常严重的问题。例如,在医疗、法律、金融等专业领域,如果大模型胡乱编造信息,可能会导致严重的后果。

AI虚假信息的泛滥:DeepSeek引发的讨论

AI生成的虚假信息:以假乱真,难以辨别

在DeepSeek爆火之后,中文互联网上利用AI生成的虚假信息呈现出泛滥之势。早在农历新年期间,就曾出现过一篇声称是英伟达创始人黄仁勋对DeepSeek看法的文章,甚至还有一篇以DeepSeek创始人梁文锋口吻回应游戏科学冯骥的公开信。这些文章措辞诚恳,细节丰富,极具煽动性,一度在网络上广泛传播,引发大量网友转发和评论。然而,这些文章很快被证实为AI伪造。

DeepSeek的幻觉率:数据对比与风险提示

过去一个月,类似的AI虚假信息有增无减。一篇名为《DeepSeek的胡编乱造,正在淹没中文互联网》的文章引起了广泛关注。作者指出,类似于DeepSeek这样的深度推理模型,在训练过程中特别注重奖惩机制,AI会为了迎合用户的意识而生成内容。不少自媒体已经开始借助AI来批量生成真假难辨的信息,并将其大量投放到互联网上。AI平台Vectara发布的大模型幻觉榜单也显示,相较于DeepSeek-V3的3.9%幻觉率,推理模型DeepSeek-R1的幻觉率高达14.3%。

AI幻觉对普通民众的影响:医疗领域的挑战

AI诊疗的风险:误导患者与监管难题

普通民众很难区分AI生成信息的真伪,这也带来了新的问题。近段时间以来,屡次出现患者拿着DeepSeek等AI的诊疗结果去医院开药的情况。有媒体评论称,AI正在成为医患关系的新挑战。部分地区的监管机构不得不紧急发文强调,严禁医院及药店等医疗场所接收人工智能等自动生成的处方。

刘庆峰:提升公众对AI技术的认知,防范幻觉数据误导

刘庆峰在两会期间接受采访时强调,普通民众对AI技术原理及生成机制的认知理解不足,极易将算法输出的“幻觉数据”误判为真实可信信息。当大模型生成的“幻觉数据”充斥互联网信息生态时,不仅会削弱公众信任,还可能影响社会稳定。

虚假信息的传播:引发恐慌,影响社会稳定

不久前,一条关于“中国80后累计死亡率为5.2%”的谣言在互联网上广为流传。如果不是对人口问题有深入了解的专家学者,普通民众很难辨别其中的错误。不少人在网络上转发相关信息,引发了不必要的恐慌情绪。中国人民大学教授李婷公开辟谣称,这则数据存在明显错误,因为专业统计数据中死亡率通常使用千分率表示,而非百分率。她推测,虚假的死亡数据很可能是由AI生成的,并通过对AI大模型的提问验证了这一观点。

应对AI幻觉:技术研发与管理机制并重

刘庆峰的建议:构建安全可信数据体系,研发幻觉治理技术

作为坚持全栈自主可控的国产大模型代表人物,刘庆峰建议从技术研发和管理机制上双管齐下,来防范AI幻觉信息的泛滥。他提出,一是构建安全可信的数据标签体系,提升内容可靠性;二是研发AIGC幻觉治理技术和平台,定期清理幻觉数据。

建立AI内容溯源机制:持续清理错误信息

“我们必须尽早建立人工智能生成内容的溯源机制,这一机制应像‘拉网’一样持续清理错误信息,并为科研机构和个人提供相应工具,帮助他们自主筛查、判断信息的真实性。”刘庆峰说。

全球AI监管趋势:法律法规的不断完善

国际AI监管条例:欧盟与美国的探索

大模型引爆市场两年来,全球已有不少针对人工智能的监管条例出台。例如,欧盟推出了《人工智能法案》,美国提出了《算法问责法案》等等,这些法案旨在规范AI的应用,保护用户权益,防范潜在风险。

中国AI监管:划定红线,规范发展

我国也相继出台了《生成式人工智能服务管理暂行办法》(以下简称《办法》)等相关监管条例,针对人工智能传播虚假信息、侵害个人信息权益、数据安全和偏见歧视等问题划定了监管红线,力求在鼓励AI创新的同时,确保其安全、可靠、可控。

拥抱AI,正视AI幻觉:发展与挑战并存

AI的未来:不可阻挡的趋势

当然,AI存在幻觉并不意味着我们就应该拒绝AI。人工智能是大势所趋,AI自主生成内容正是大语言模型的突出特点,也是最具想象力的技术突破。我们既要坚决反对AI幻觉数据在互联网上的泛滥,但同时也要审慎地看待大模型的“AI幻觉”。

讯飞星火的探索:降低知识回复错误率

过去两年来,行业中也有不少针对AI幻觉问题的有益探索和尝试。例如今年1月,讯飞星火推出了基于智能体的全新长文本框架,并在行业内首发了句子级溯源功能,可以利用大规模网页和书籍数据进行知识关联式合成,使得知识回复的错误率降低了40%。

行业应用与数据积累:降低幻觉,提升智能水平

在国产大模型逐渐在千行百业落地应用过程中,诸如医疗、能源、教育等对模型准确率要求更高的行业龙头企业也与AI厂商们共同探索,不断消除AI幻觉的影响。此前,国家能源集团与科大讯飞合作的智能无人评审系统,通过大量行业知识的学习与AI技术创新,使得系统的智能评审准确率达97%,实现对非招标采购全类别、全评审方式全覆盖,在国资委网站上被作为典型案例推荐。

与AI共存:机遇与挑战

尤其是在持续深入落地行业过程中,大量来自行业内部的真实语料质量数据被积淀下来,可以持续反哺行业专业大模型的训练与开发,降低模型的幻觉程度,不断提升模型在专业领域的智能水平。此前,讯飞就凭借在医疗、教育等行业的多年深耕,积累了亿级的高质量医学数据以及海量教育数据集。

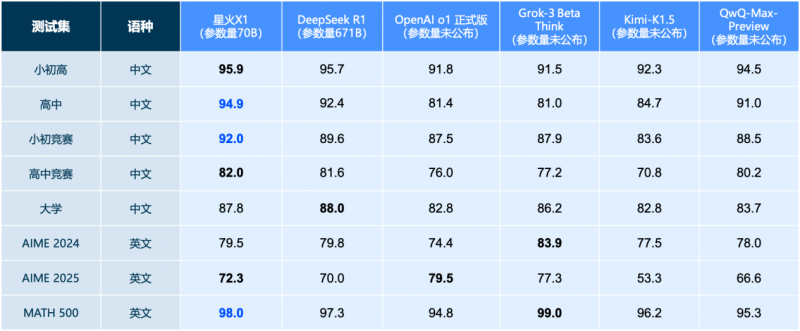

依托这些多行业、多领域的高质量数据集,讯飞星火的AI幻觉程度大幅降低。最新升级的推理模型星火X1仅用70B参数规模,就实现了数学能力对标671B参数规模的DeepSeek-R1。AIGC已经是不可阻挡的未来,我们即将迎来一个与AI共存的时代。但在大模型尚处于早期技术发展阶段的当下,AI幻觉仍然是一个无法彻底根治的问题。这既是以概率为基础的大语言模型的固有特性,同样也是我们必须克服的挑战。